Nodos principales

Aprende sobre los nodos principales de ComfyUI para manipulación de imágenes, condición y más. Construye potentes flujos de trabajo de arte con IA.

Imagen

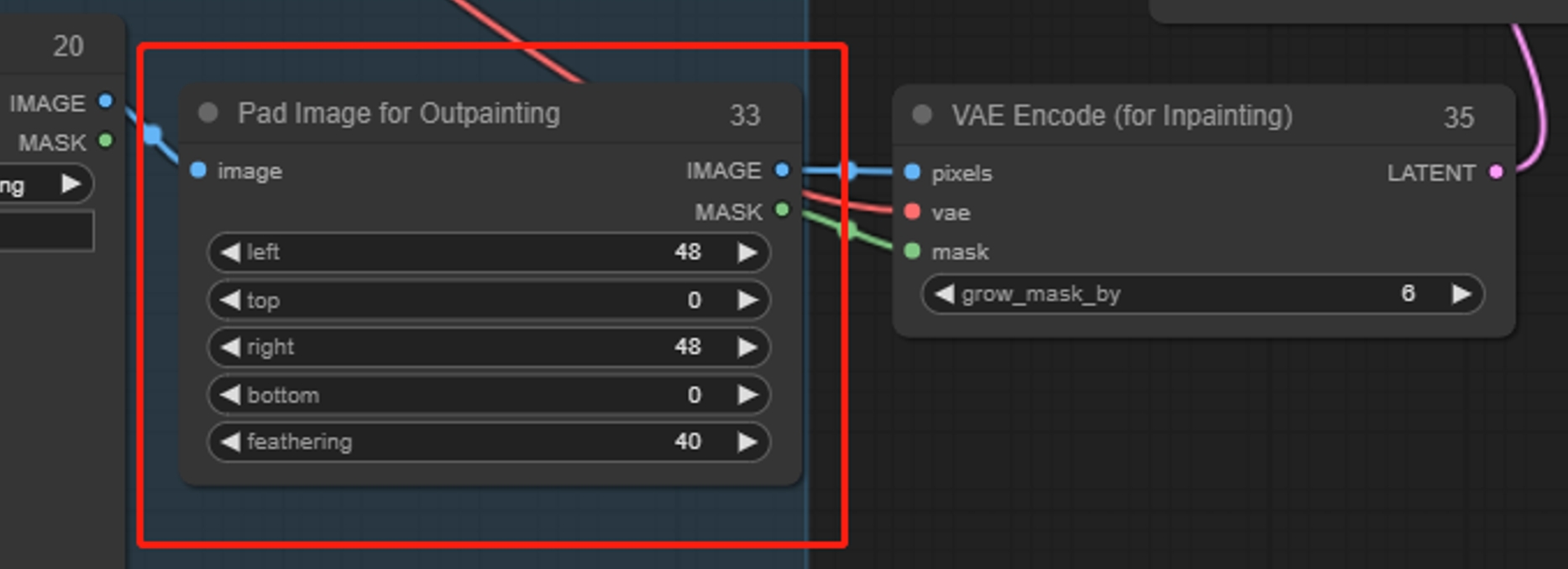

Pad Image for Outpainting

Rellena y extiende la imagen, similar a la expansión. Primero aumenta el tamaño de la imagen y luego dibuja el área expandida como una máscara. Se recomienda usar VAE Encode (para Inpainting) para asegurar que la imagen original permanezca sin cambios.

Parámetros:

left、top、right、bottom: Cantidades de relleno para izquierda, arriba, derecha y abajo

feathering: Grado de difuminado en los bordes

Save Image

Load Image

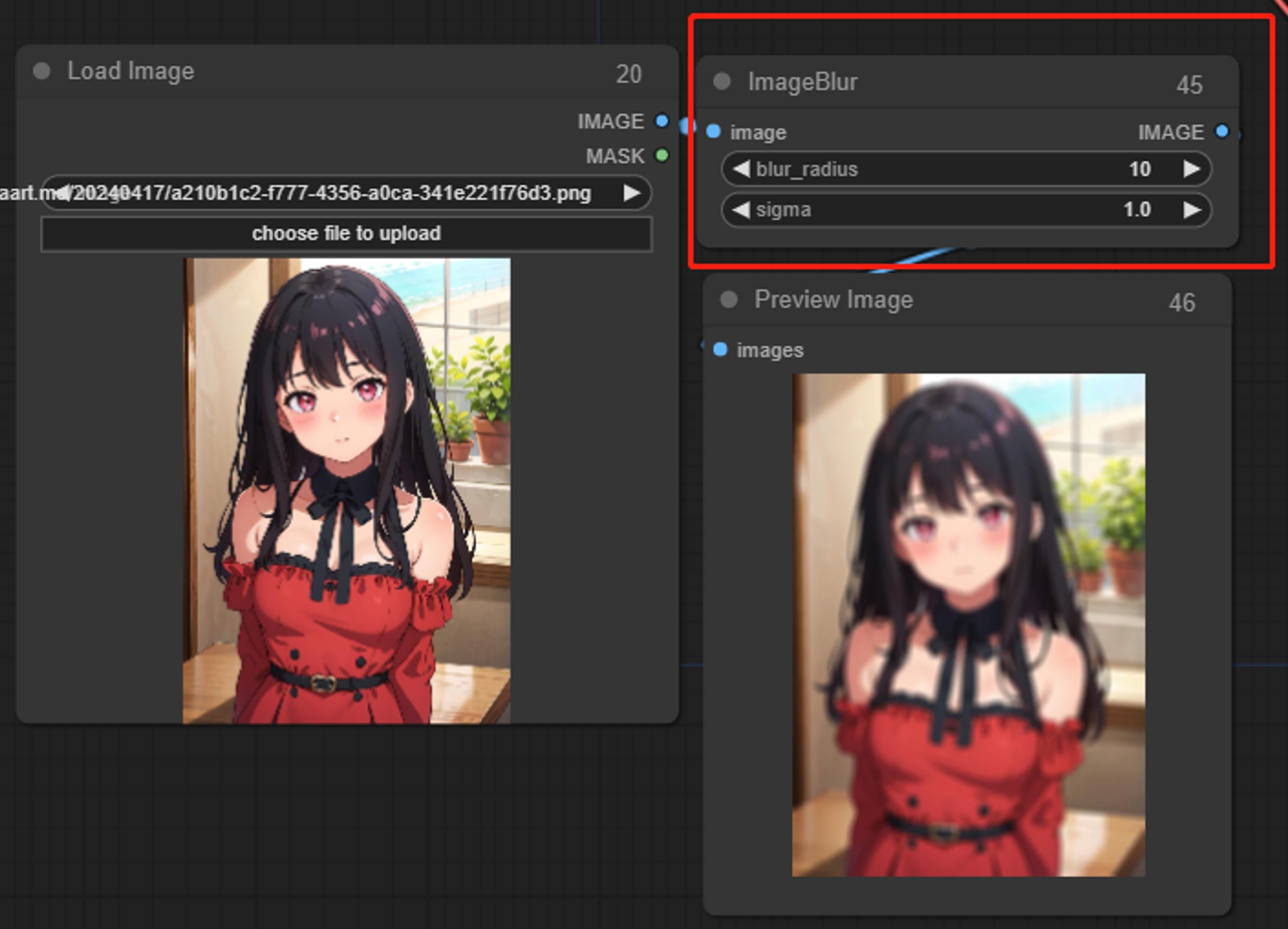

ImageBlur

Agrega un efecto de desenfoque a la imagen

Parámetros:

Sigma: Cuanto menor sea el valor, más concentrado estará el desenfoque alrededor del píxel central.

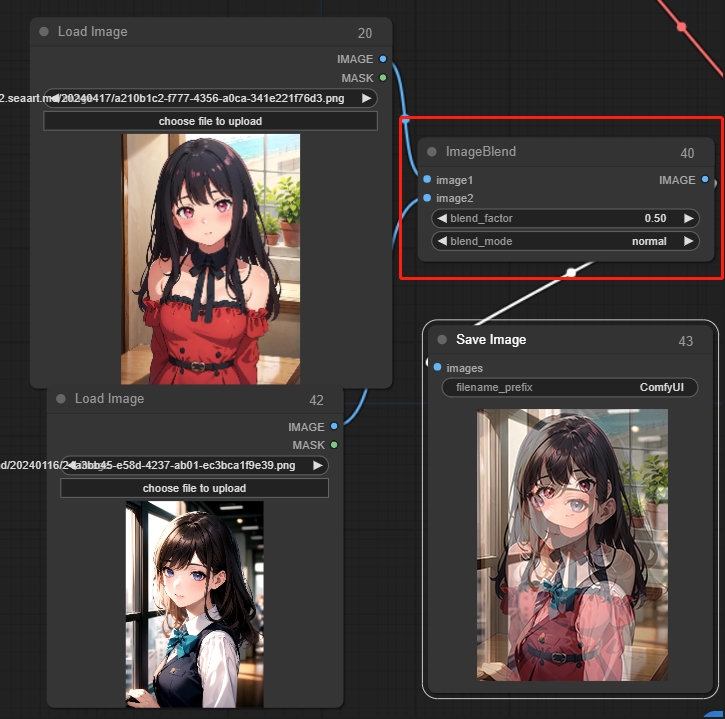

Image Blend

Fusiona dos imágenes usando transparencia

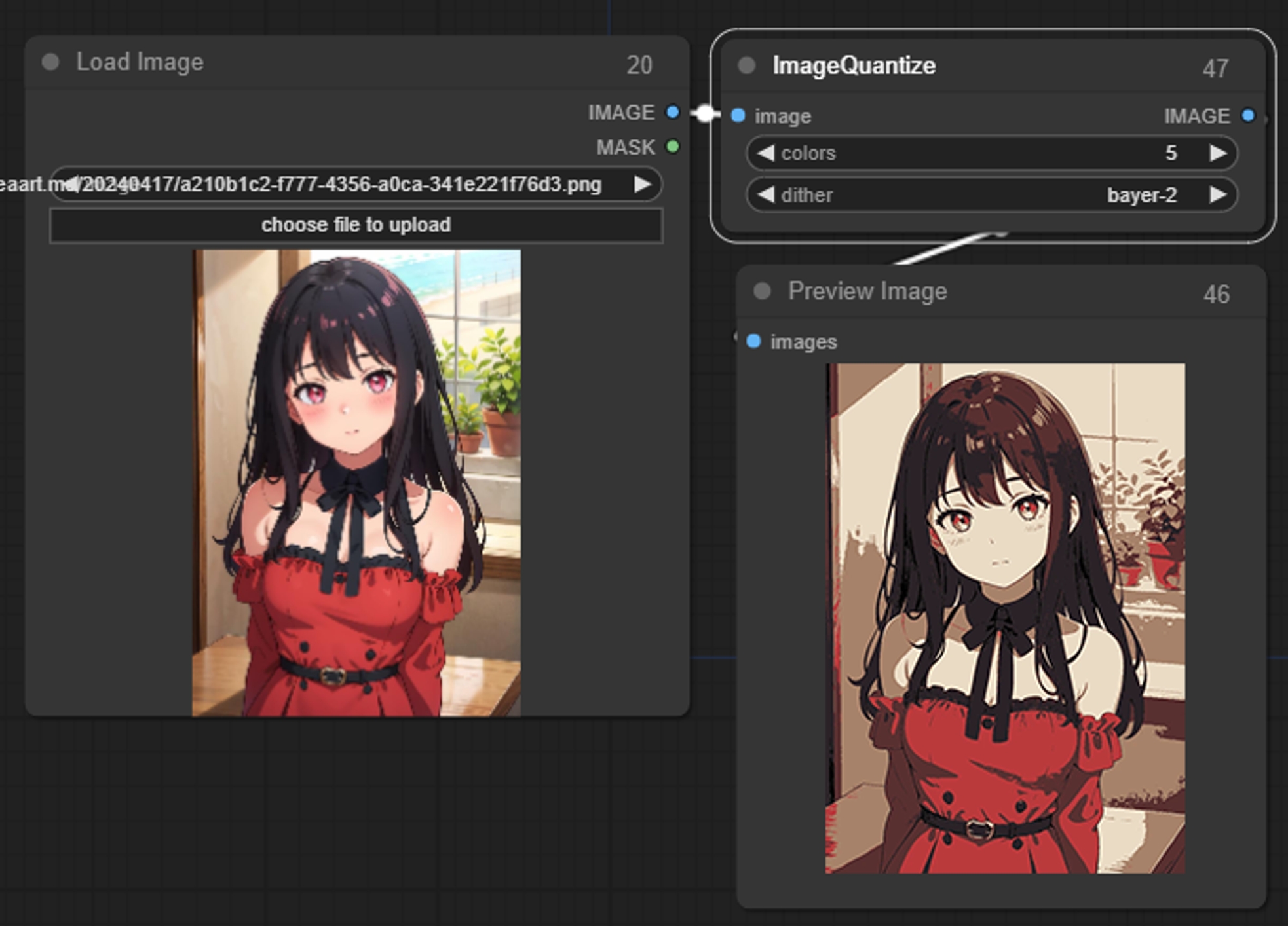

Image Quantize

Reduce el número de colores de la imagen

Parámetros:

colors: Cuantiza el número de colores de la imagen. Si se establece en 1, la imagen tendrá un solo color.

dither: Si se va a utilizar difuminado para hacer que la imagen cuantizada aparezca más suave.

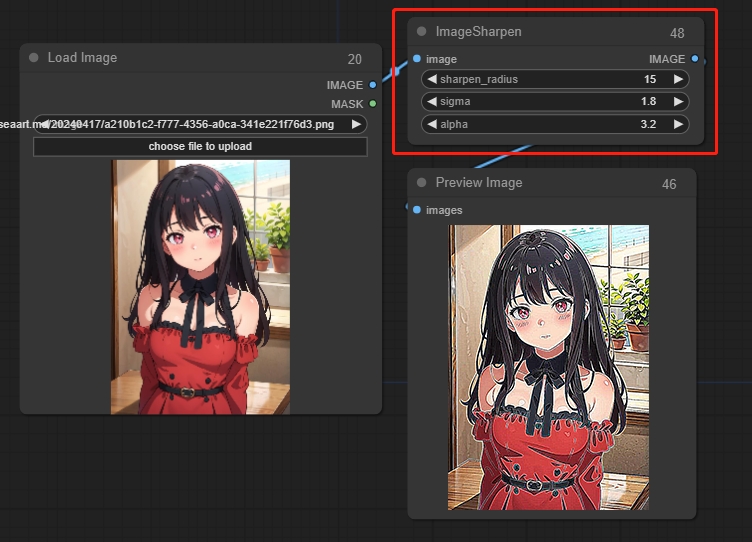

Image Sharpen

Parámetros:

sigma: Cuanto menor sea el valor, más concentrada estará la nitidez alrededor del píxel central.

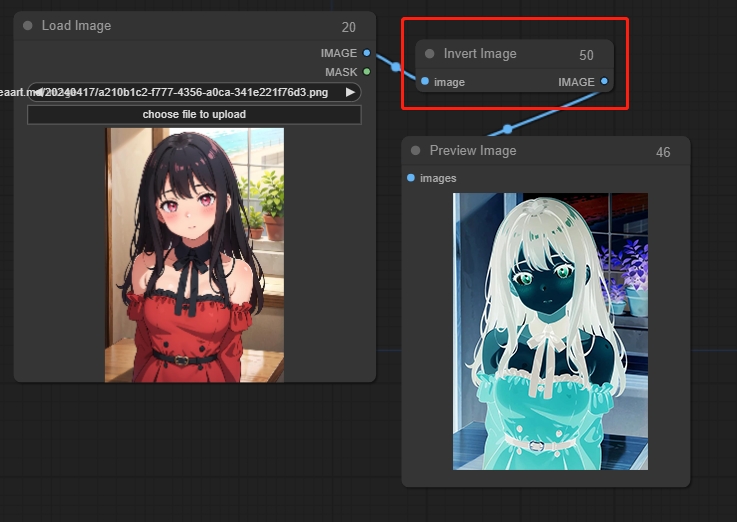

Invert Image

Invierte los colores de imagen.

Ampliación (Upscaling)

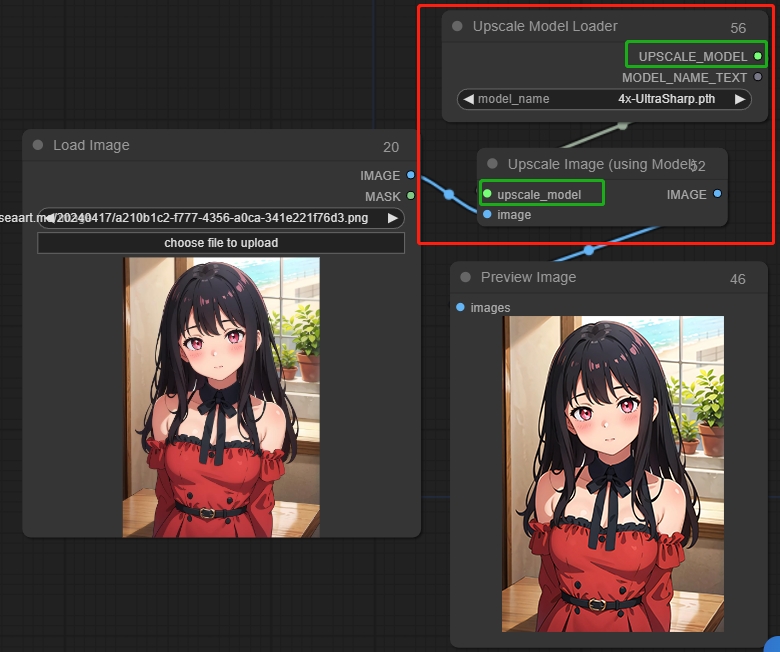

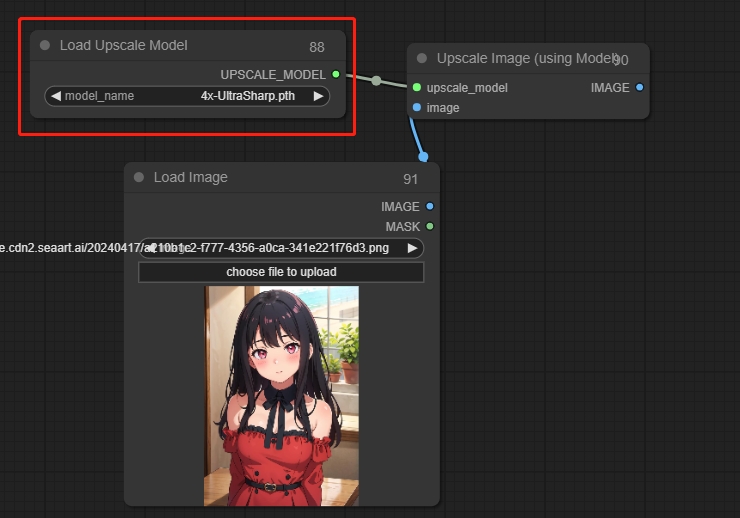

9.1 Upscale Image (usando modelo)

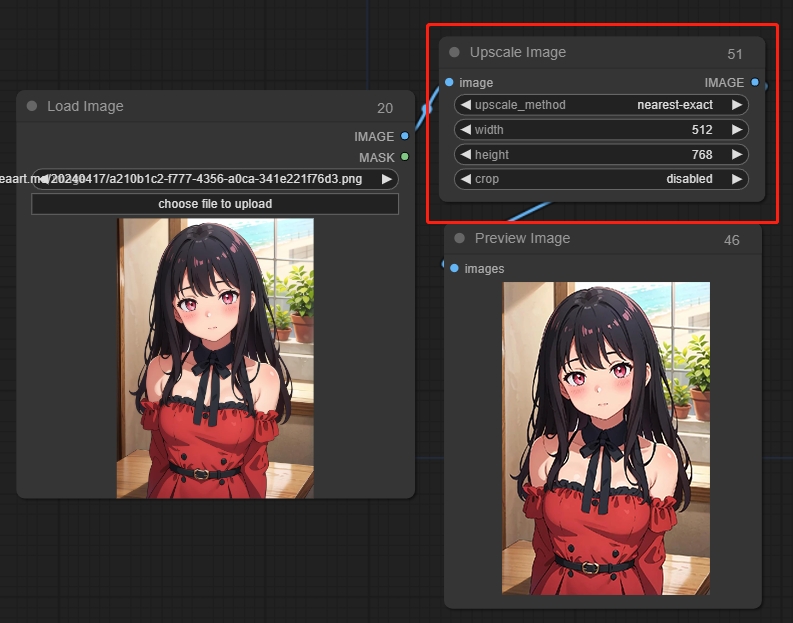

9.2 Upscale Image

El nodo Upscale Image puede utilizarse para redimensionar imágenes de píxeles.

Parámetros:

upscale_method: Selecciona el método de relleno de píxeles.

width: La anchura ajustada de la imagen

height: La altura ajustada de la imagen

crop: Si se recorta la imagen

Preview Image

Loaders

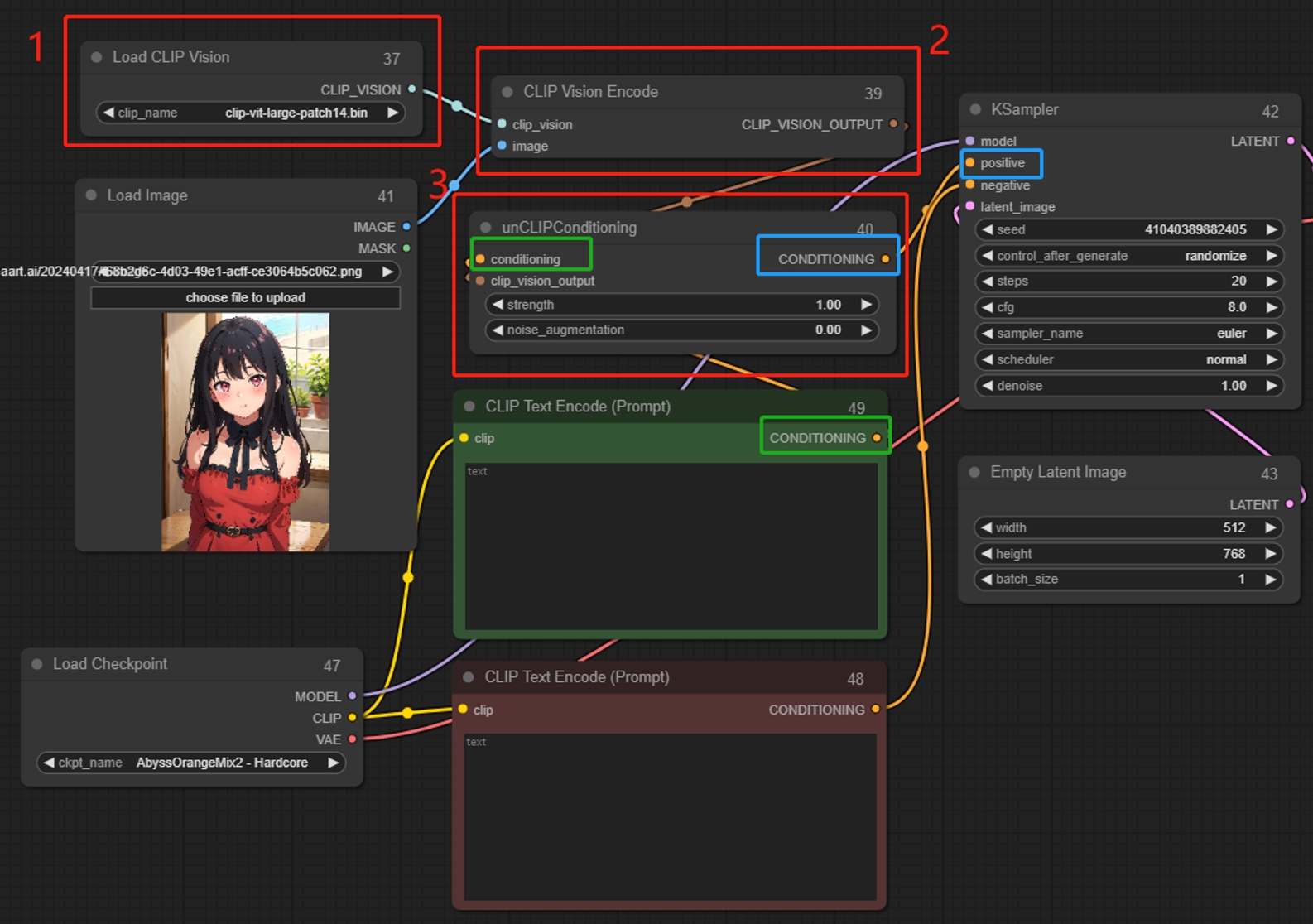

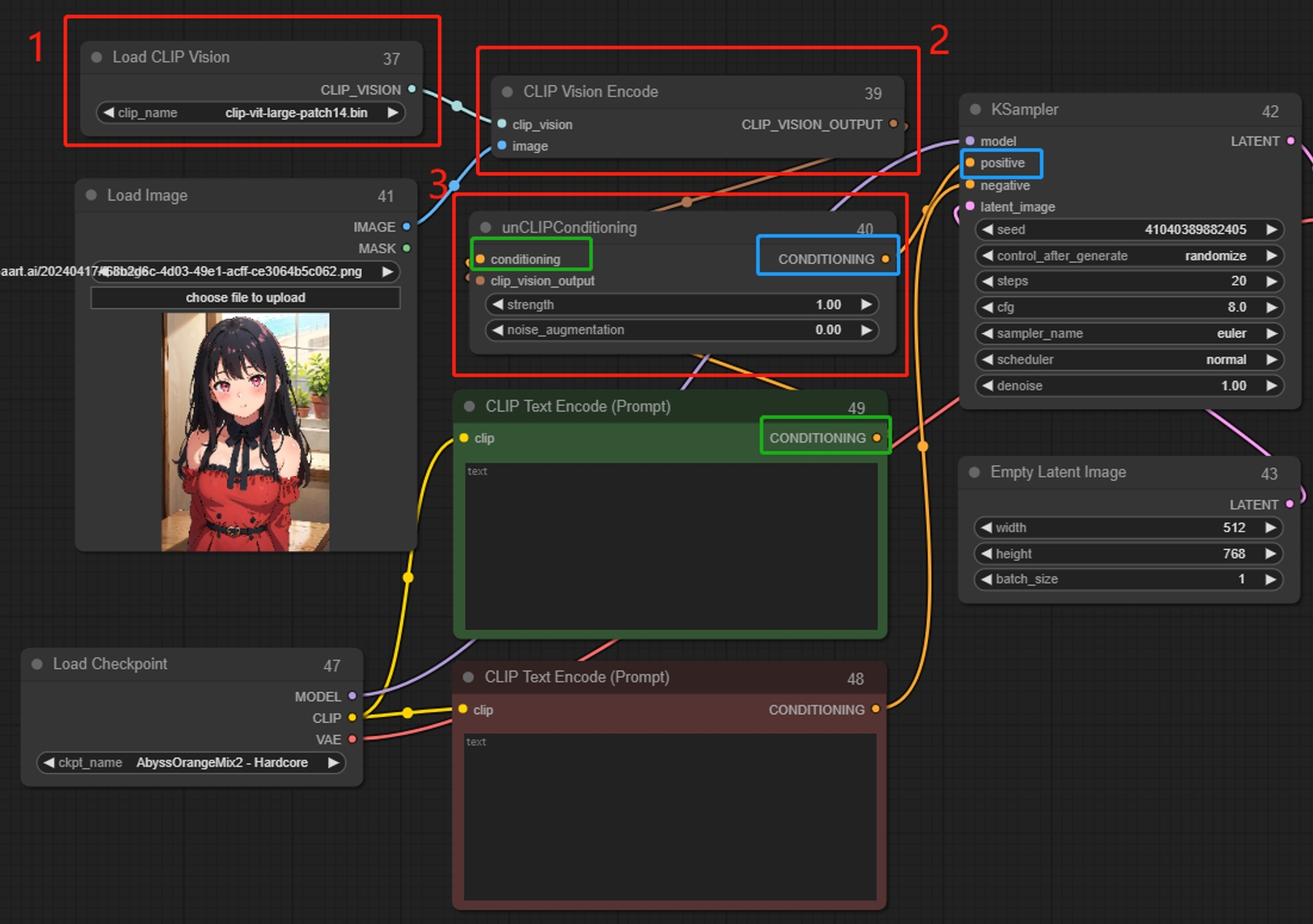

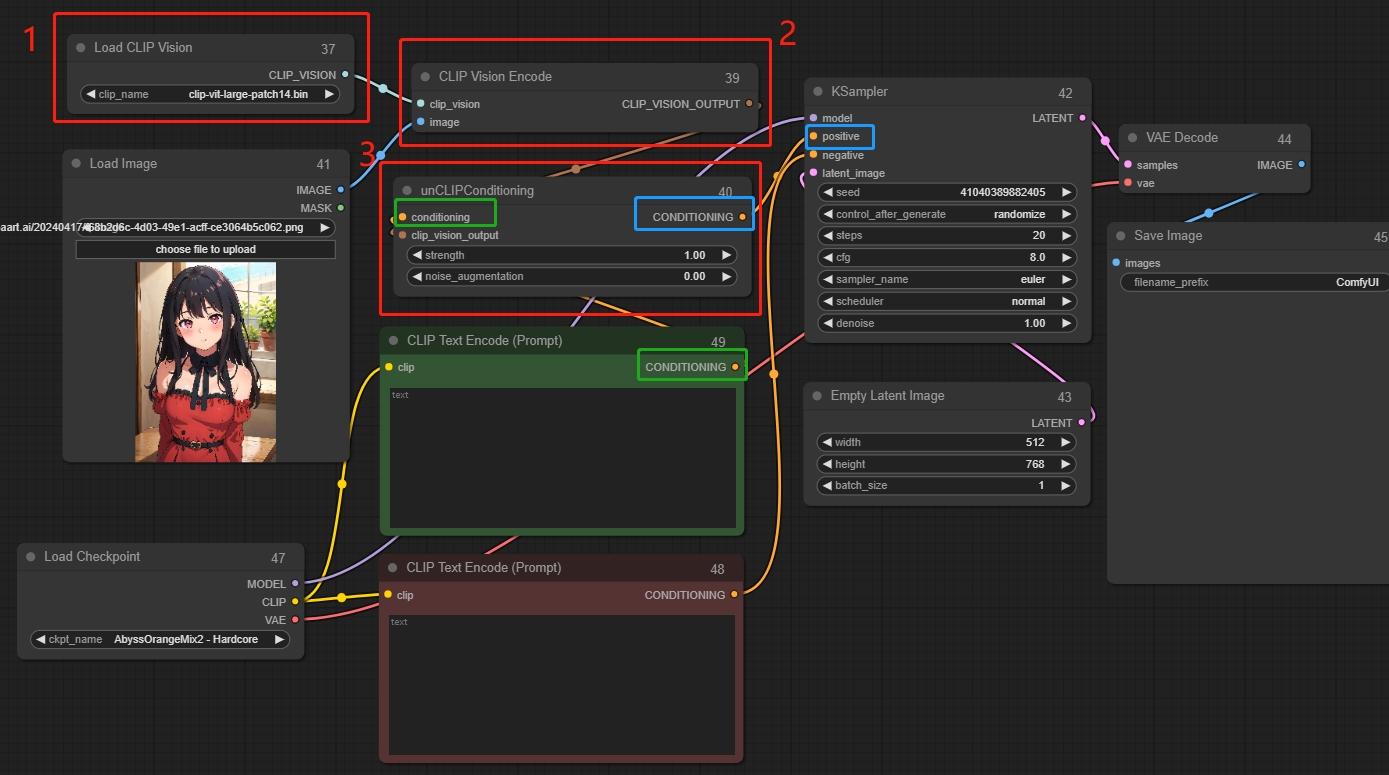

Load CLIP Vision

Descodifica la imagen para formar descripciones (prompts), y luego conviértelas en entradas condicionales para el muestreador. A partir de las descripciones decodificadas (prompts), generar nuevas imágenes similares. Se pueden utilizar varios nodos a la vez. Adecuado para transformar conceptos, cosas abstractas, utilizado en combinación con Clip Vision Encode.

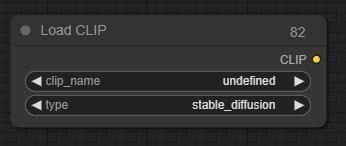

Load CLIP

El nodo Load CLIP se utiliza para cargar un modelo CLIP específico; los modelos CLIP codifican indicaciones de texto que guían el proceso de difusión.

*Conditional diffusion models are trained using a specific CLIP model, using a different model than the one which it was trained with is unlikely to result in good images. The Load Checkpoint node automatically loads the correct CLIP model.

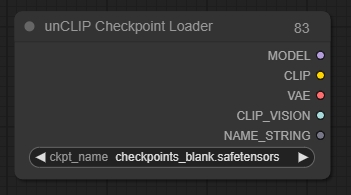

unCLIP Checkpoint Loader

El nodo unCLIP Checkpoint Loader se puede utilizar para cargar un modelo de difusión diseñado específicamente para funcionar con unCLIP. Los modelos de difusión unCLIP se utilizan para eliminar el ruido de los latentes, condicionados no solo por el texto proporcionado, sino también por las imágenes suministradas. Este nodo también proporcionará los modelos adecuados de VAE, CLIP y CLIP vision.

*Aunque este nodo puede utilizarse para cargar todos los modelos de difusión, no todos los modelos de difusión son compatibles con unCLIP.

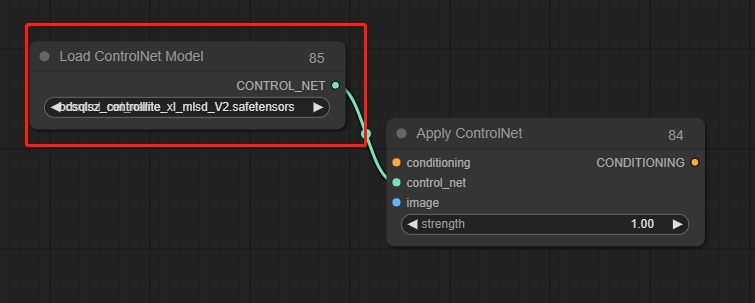

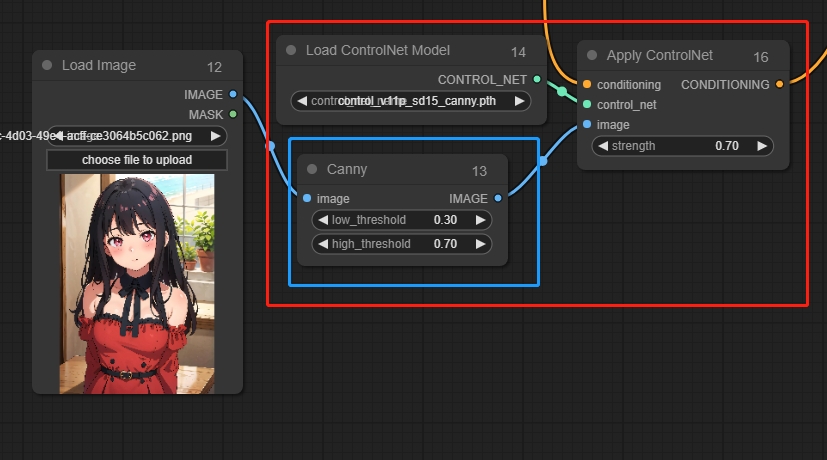

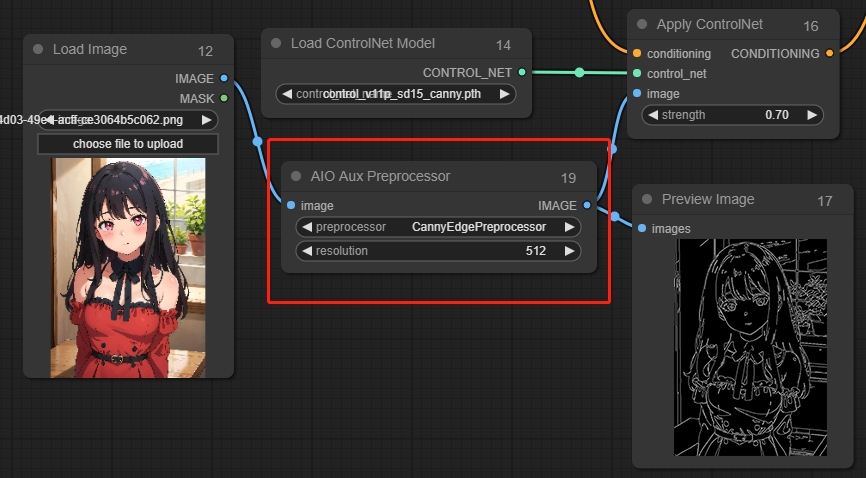

Load ControInet Model

El nodo Load ControlNet Model se puede utilizar para cargar un modelo de ControlNet, usado en conjunto con Apply ControlNet.

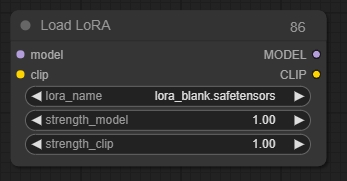

Load LoRA

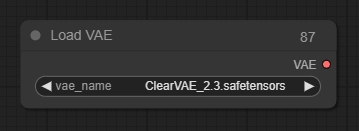

Load VAE

Load Upscale Model

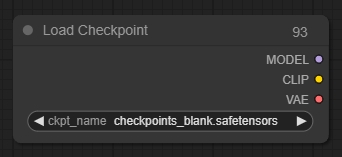

Load Checkpoint

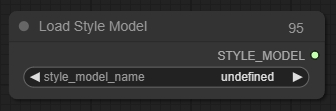

Load Style Model

El nodo Load Style Model se puede utilizar para cargar un modelo de estilo. Los modelos de estilo pueden usarse para proporcionar al modelo de difusión una pista visual sobre el tipo de estilo que debe tener el latente una vez eliminado el ruido.

*Actualmente, solo se admiten modelos de estilo T2IAdaptor.

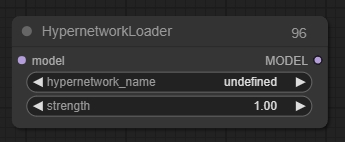

Hypernetwork Loader

El nodo Hypernetwork Loader se puede utilizar para cargar una hiperred. De manera similar a las LoRAs, se usan para modificar el modelo de difusión y alterar la forma en que se eliminan el ruido de los latentes. Los casos de uso típicos incluyen agregar al modelo la capacidad de generar en ciertos estilos o mejorar la generación de ciertos sujetos o acciones. Incluso se pueden encadenar múltiples hiperredes para modificar aún más el modelo.

Condicionamiento

Aplica ControlNet

Load ControlNet model, que puede conectar múltiples nodos ControlNet.

Parámetros:

strength: Cuanto mayor sea el valor, más fuerte será la restricción sobre la imagen.

*La imagen de ControlNet debe ser la imagen preprocesada correspondiente; por ejemplo, la imagen preprocesada con Canny debe corresponder al grafo preprocesado con Canny. Por lo tanto, es necesario agregar nodos correspondientes entre la imagen original y ControlNet para preprocesarla en el grafo preprocesado

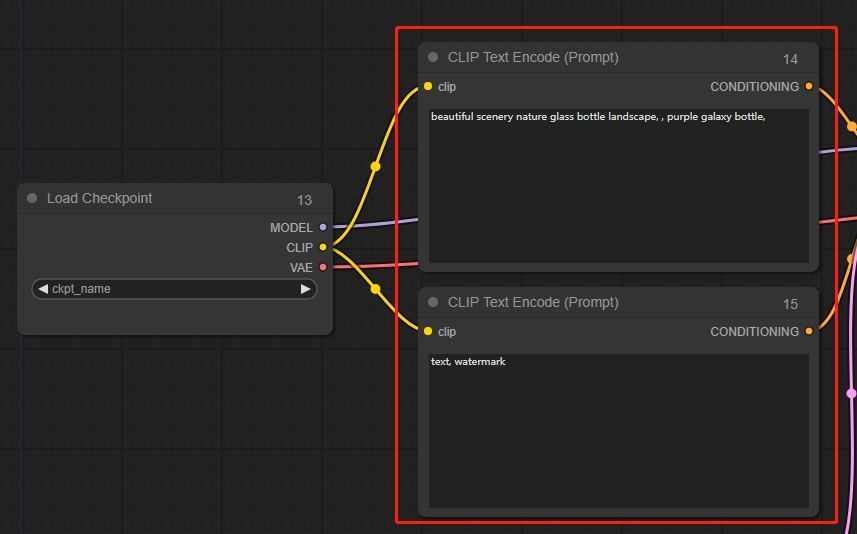

CLIP Text Encode (Prompt)

Introduce textos de indicaciones, incluyendo indicaciones positivas y negativas.

CLIP Vision Encode

Decodifica la imagen para generar descripciones (prompts) y luego conviértelas en entradas condicionales para el sampler. Basándose en las descripciones decodificadas (prompts), genera nuevas imágenes similares. Se pueden usar múltiples nodos juntos. Es adecuado para transformar conceptos o cosas abstractas y se utiliza en conjunto con Load Clip Vision.

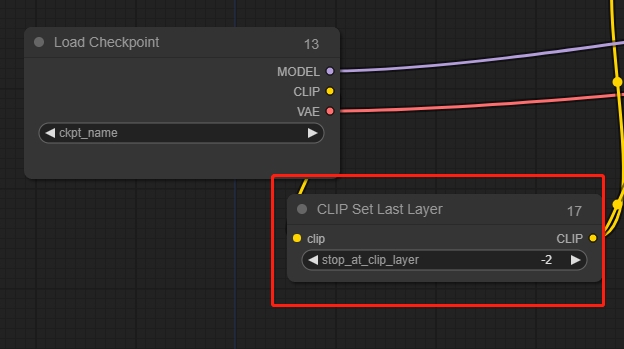

CLIP Set Last Layer

Clip Skip, generalmente se establece en -2.

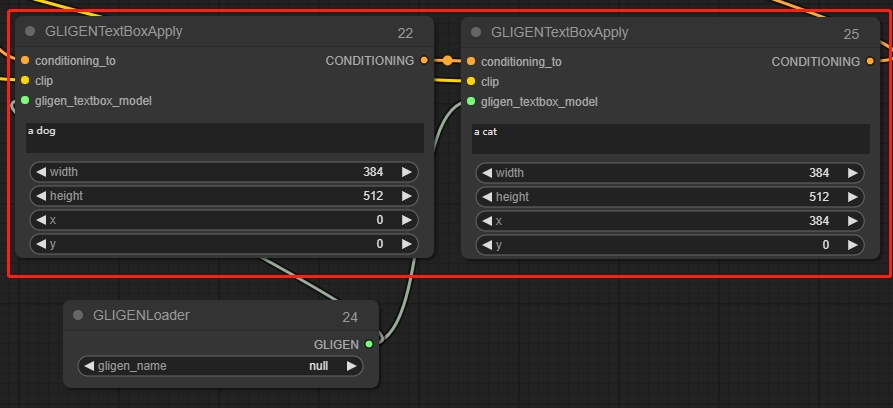

GLIGEN Textbox Apply

Guía las indicaciones para que generen en la porción especificada de la imagen.

*El origen del sistema de coordenadas en ComfyUI se encuentra en la esquina superior izquierda.

unCLIP Conditioning

Las imágenes codificadas a través del modelo CLIP vision proporcionan una guía visual adicional para el modelo unCLIP. Este nodo puede encadenarse para ofrecer múltiples imágenes como guía.

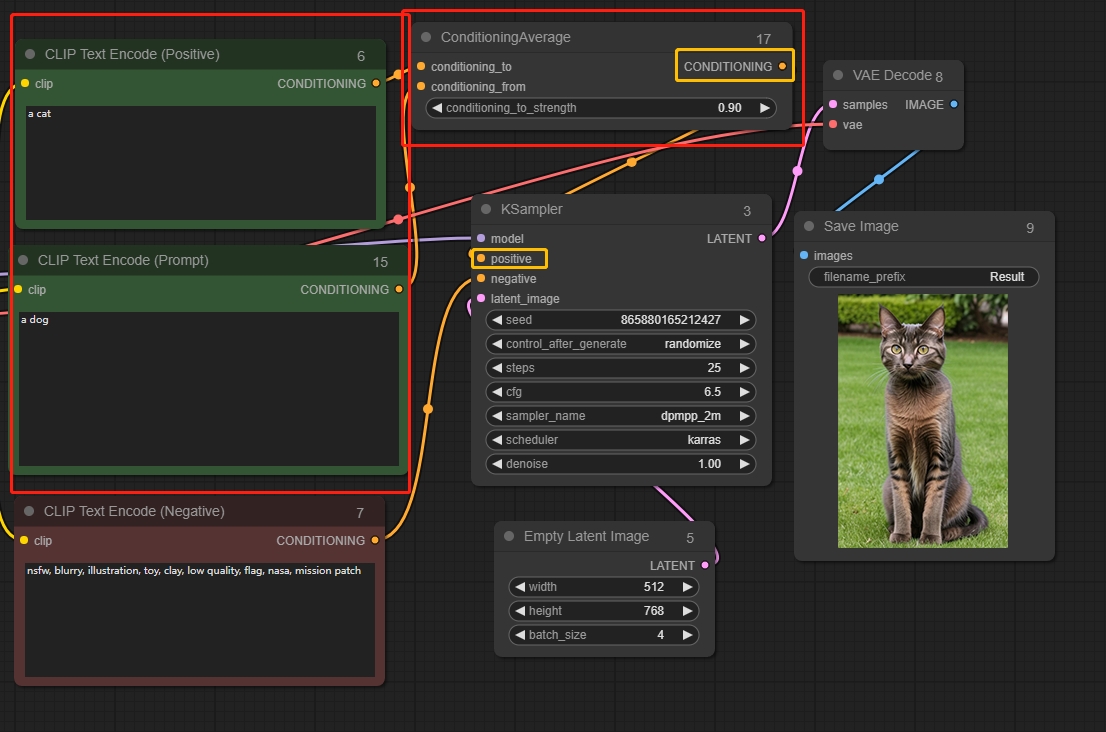

Conditioning Average

Mezcla dos fuentes de información según su intensidad. Cuando conditioning_to_strength se establece en 1, la difusión estará influenciada únicamente por conditioning_to. Cuando conditioning_to_strength se establece en 0, la difusión de la imagen estará influenciada únicamente por conditioning_from.

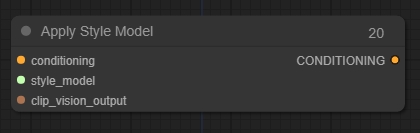

Apply Style Model

Puedes usarlo para proporcionar una guía visual adicional al modelo de difusión, especialmente en cuanto al estilo de las imágenes generadas.

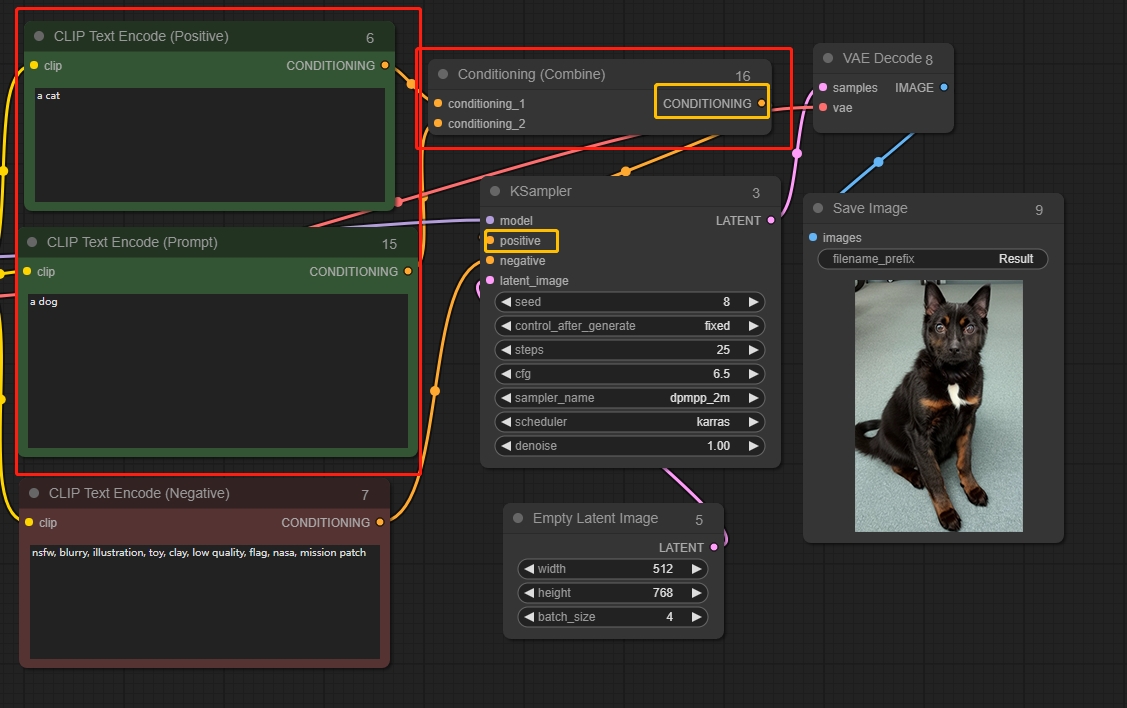

Conditioning (Combine)

Mezcla dos fuentes de información.

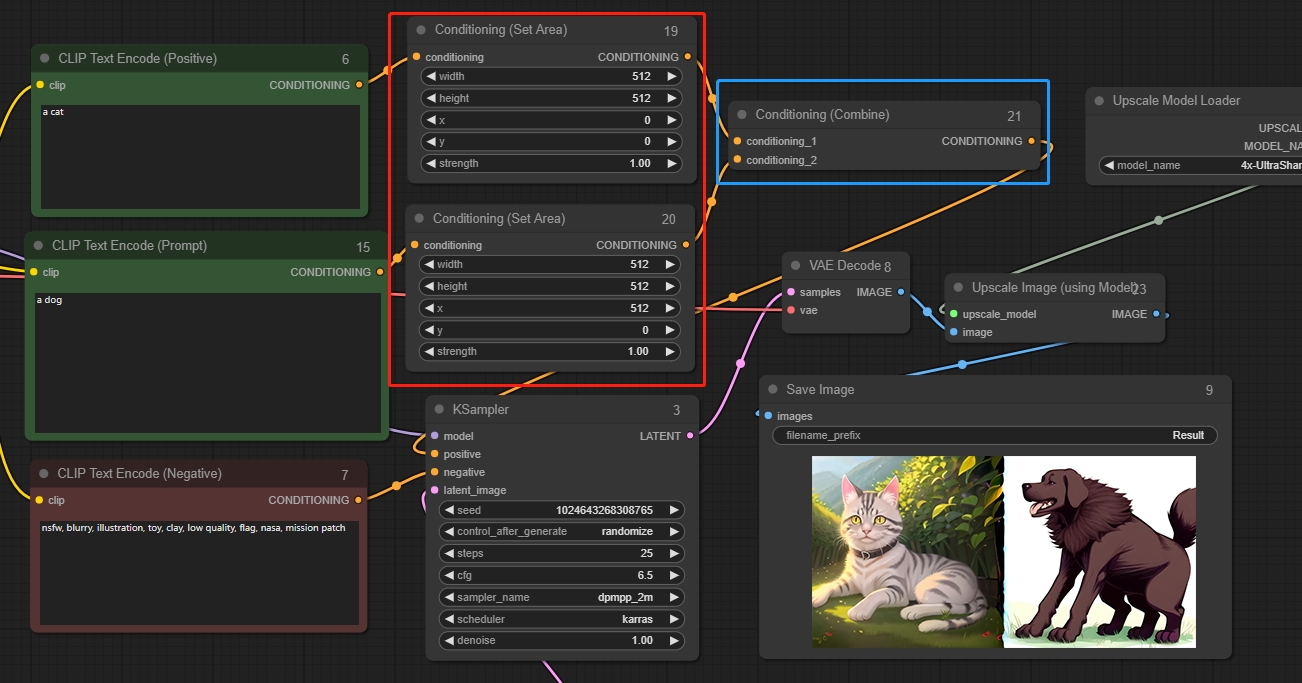

Conditioning (Set Area)

Conditioning (Set Area) se puede usar para limitar la región afectada dentro de un área específica de la imagen. Usado junto con Conditioning (Combine), permite un mejor control sobre la composición de la imagen final.

Parámetros:

width: El ancho de la región de control

height: La altura de la región de control

x: La coordenada x del origen de la región de control

y: La coordenada y del origen de la región de control

strength: La intensidad de la información condicional

*El origen del sistema de coordenadas en ComfyUI se encuentra en la esquina superior izquierda.

Como se muestra en la figura: establece el lado izquierdo como "gato" y el lado derecho como "perro".

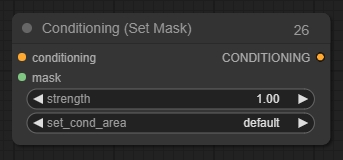

Conditioning (Set Mask)

Conditioning (Set Mask) se puede usar para limitar un ajuste dentro de una máscara específica. Usado junto con el nodo Conditioning (Combine), permite un mejor control sobre la composición de la imagen final.

Latent

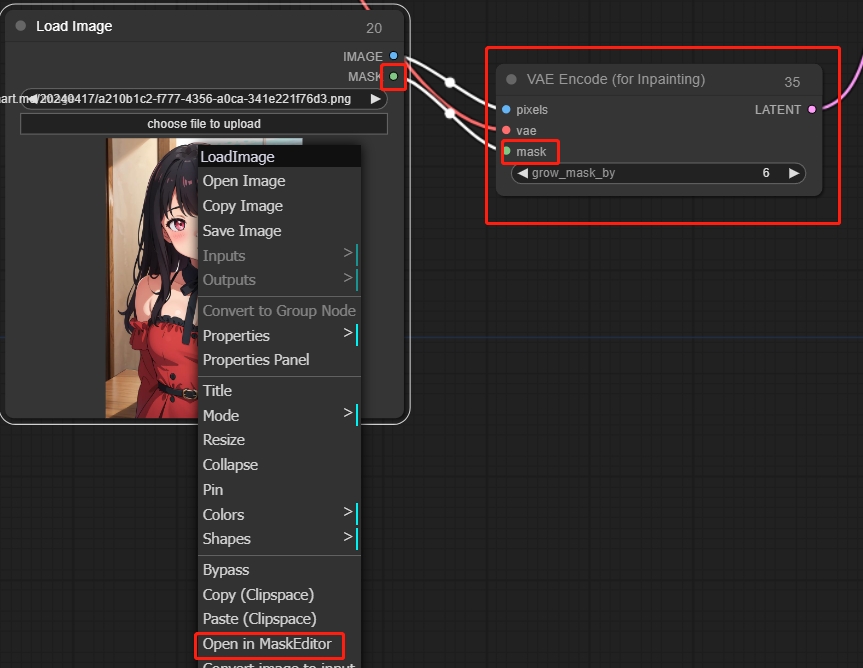

VAE Encode(for Inpainting)

Aplicable para repintado parcial. Haz clic derecho para realizar el repintado parcial mediante Abrir en MaskEditor.

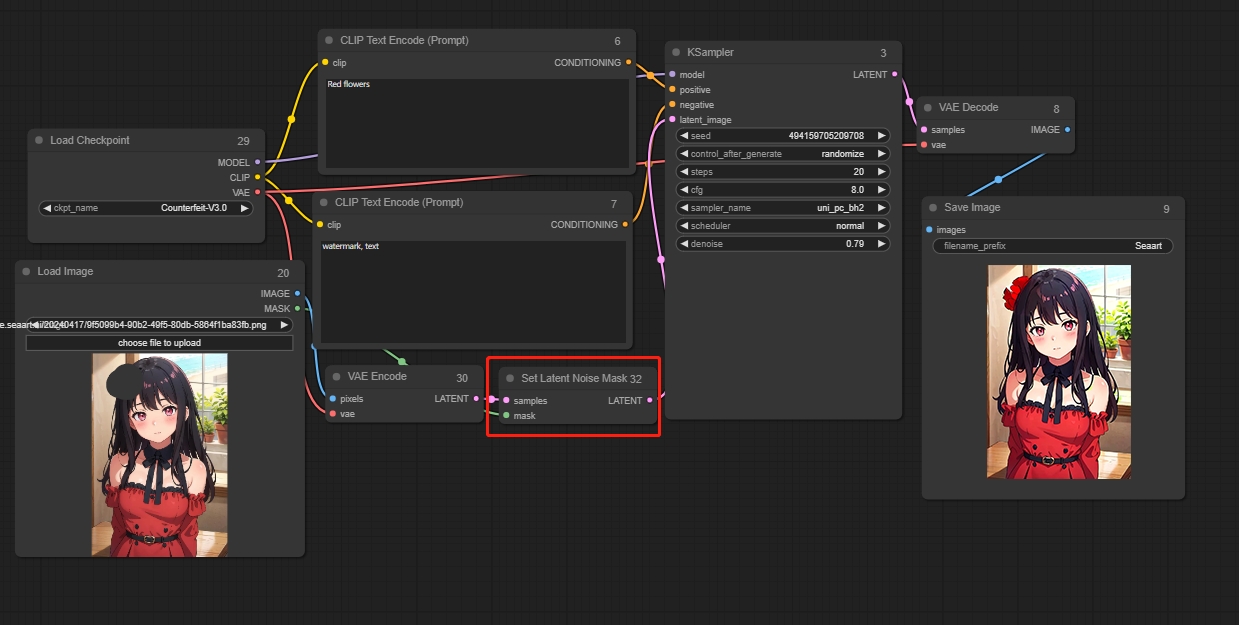

Set Latent Noise Mask

El segundo método para el repintado parcial consiste primero en codificar la imagen mediante un codificador VAE, para transformarla en contenido reconocible en el espacio latente. Luego, se regenera la parte enmascarada dentro de ese espacio latente.

En comparación con el método VAE Encode (for Inpainting), este enfoque puede comprender mejor el contenido que necesita ser regenerado, lo que reduce la probabilidad de generar imágenes incorrectas. Hará referencia a la imagen que se va a rehacer.

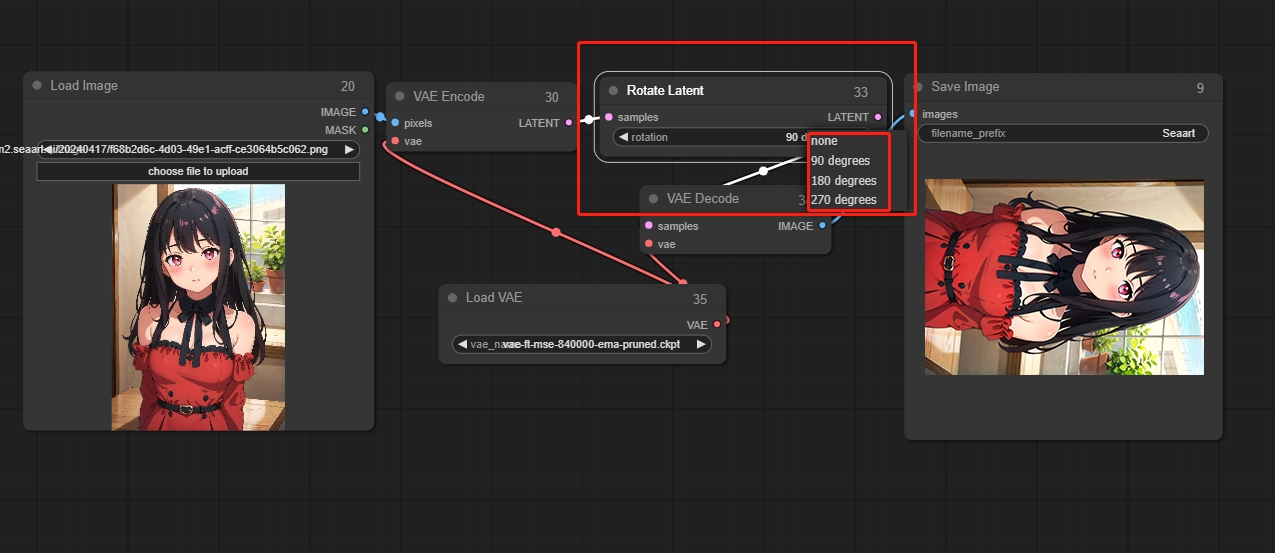

Rotate Latent

Gira la imagen en sentido horario.

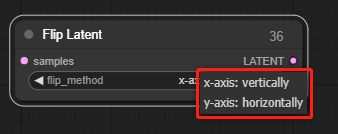

Flip Latent

Voltea la imagen horizontal o verticalmente.

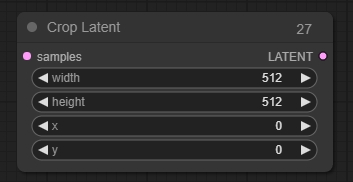

Crop Latent

Se utiliza para recortar la imagen y darle una nueva forma.

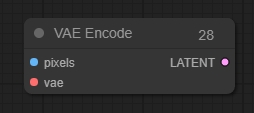

VAE Encode

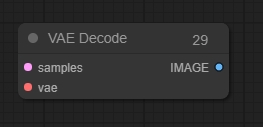

VAE Decode

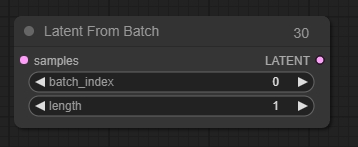

Latent From Batch

Extrae imágenes latentes de lotes. El nodo Latent From Batch se puede usar para seleccionar una imagen latente o un segmento de imagen de un lote. Esto es muy útil en flujos de trabajo donde se necesita aislar imágenes latentes o imágenes específicas.

Parámetros:

batch_index: El índice de la primera imagen latente que se desea seleccionar.

length: La cantidad de imágenes latentes que se desea extraer.

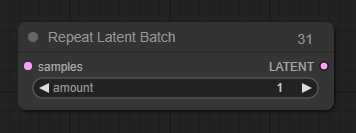

Repeat Latent Batch

Repite un lote de imágenes, útil para crear múltiples variaciones de una imagen en un flujo de trabajo de Imagen a imagen.

Parámetros:

amount: La cantidad de repeticiones.

Rebatch Latents

Puedes usarlo para dividir o fusionar lotes de imágenes en espacio latente.

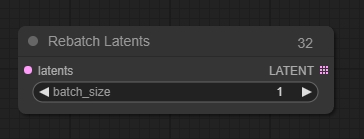

Upscale Latent

Ajusta la resolución de las imágenes en el espacio latente, rellenando los píxeles.

Parámetros:

upscale_method: El método para rellenar los píxeles.

width: El ancho de la imagen ajustada en el espacio latente.

height: La altura de la imagen ajustada en el espacio latente.

crop: Indica si la imagen debe recortarse.

*La imagen ampliada en el espacio latente puede sufrir degradación al ser decodificada mediante VAE. Se puede usar KSampler para un muestreo secundario y así reparar la imagen.

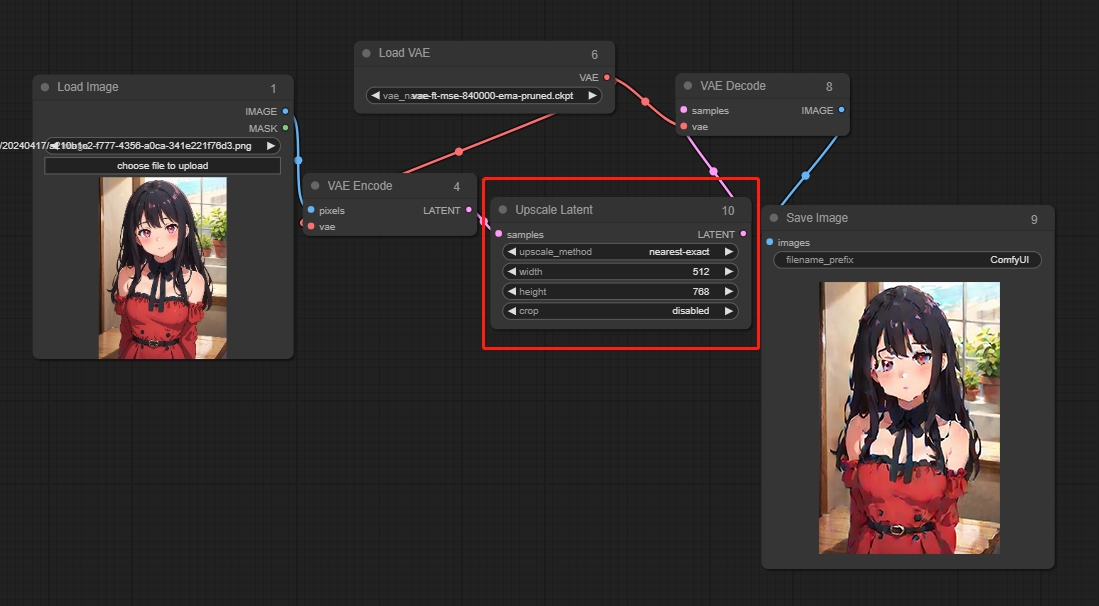

Latent Composite

Superpone una imagen sobre otra.

Parámetros:

x: La coordenada x de la posición de superposición de la capa superior.

y: La coordenada y de la posición de superposición de la capa superior.

feather: Indica el grado de difuminado en los bordes.

*La imagen debe estar codificada (VAE Encode) en el espacio latente.

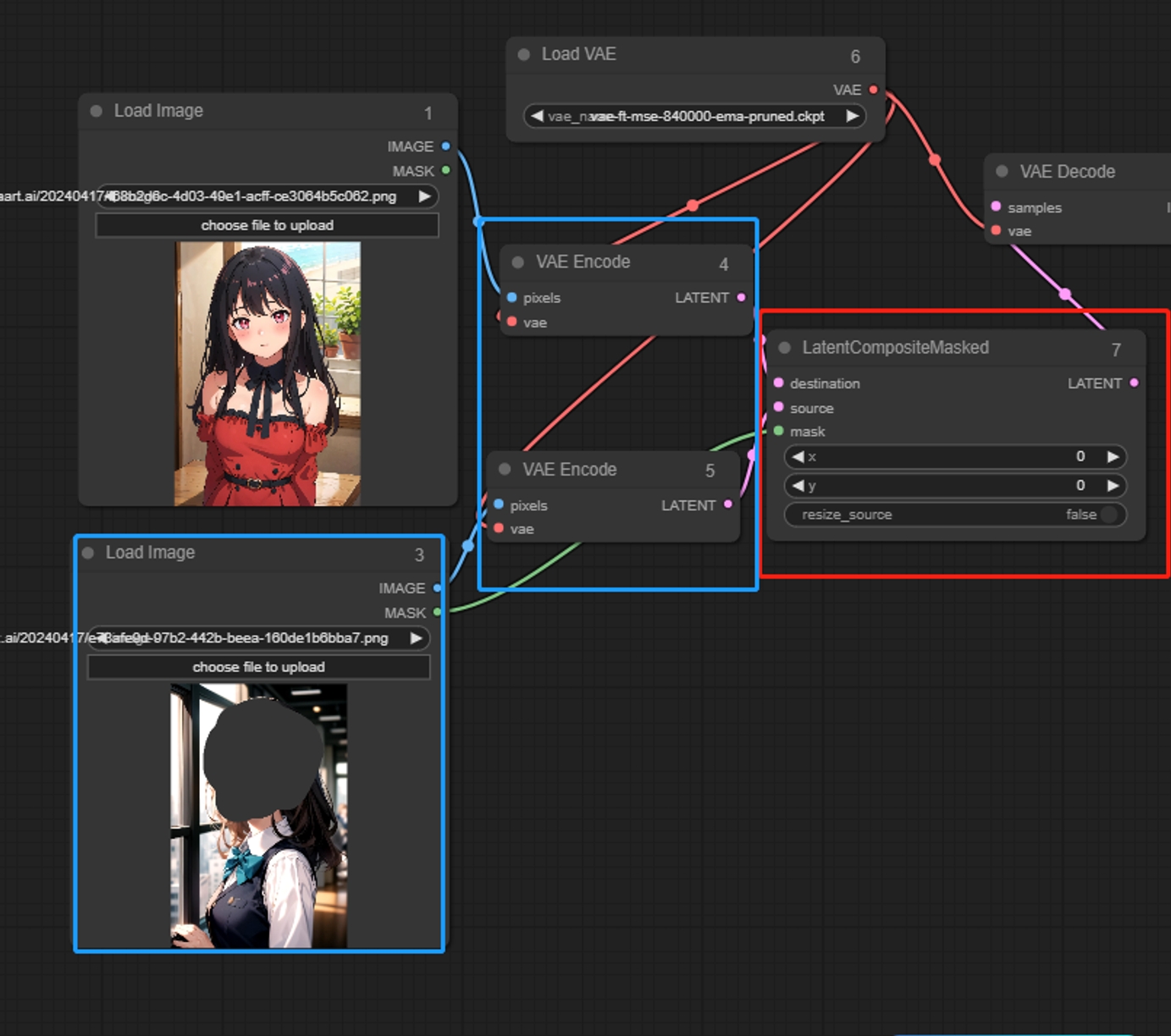

Latent Composite Masked

Superpone una imagen con una máscara sobre otra, superponiendo únicamente la parte enmascarada.

Entrada

destination: La imagen en espacio latente subyacente. source: La imagen en espacio latente que se superpone.

Parámetros:

x: La coordenada x de la región de superposición.

y: La coordenada y de la región de superposición.

resize_source: Indica si se debe ajustar la resolución de la región enmascarada.

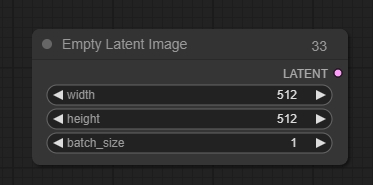

Empty Latent Image

El nodo Empty Latent Image se puede usar para crear un conjunto de nuevas imágenes latentes vacías. Estas imágenes latentes pueden luego utilizarse en flujos de trabajo como Texto a imagen, añadiéndoles ruido y eliminándolo mediante nodos de muestreo.

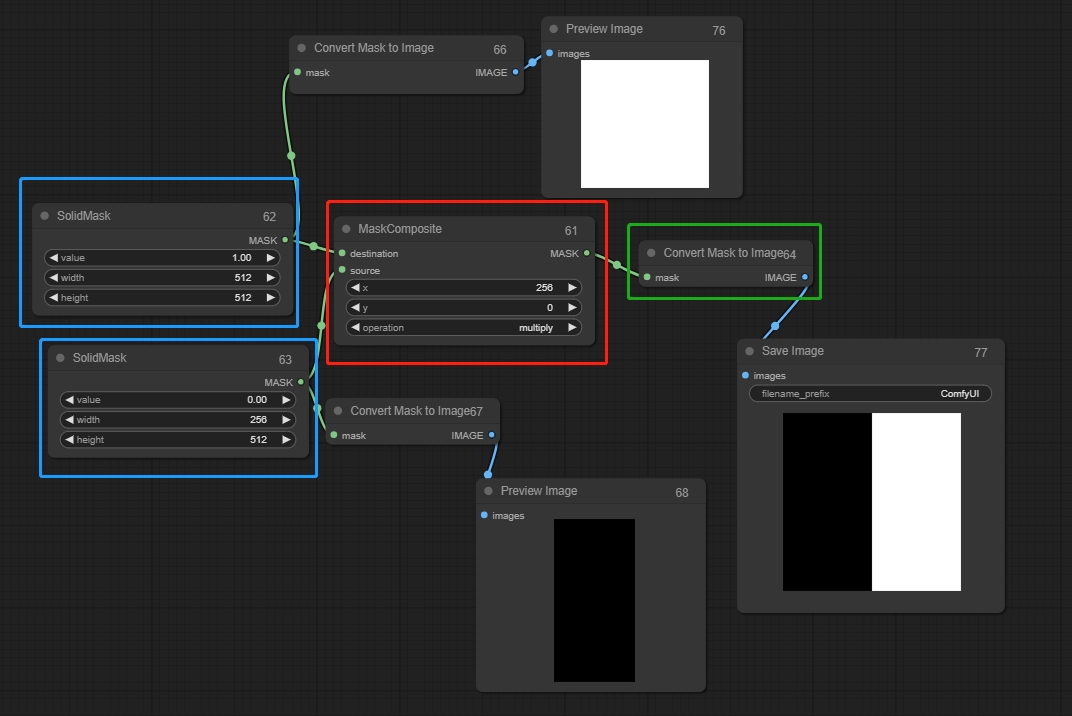

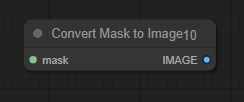

Mask

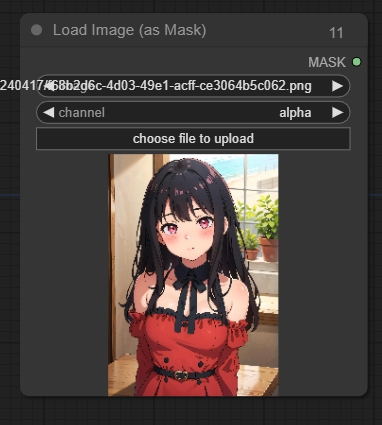

Load Image As Mask

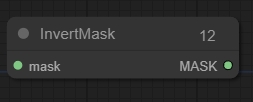

Invert Mask

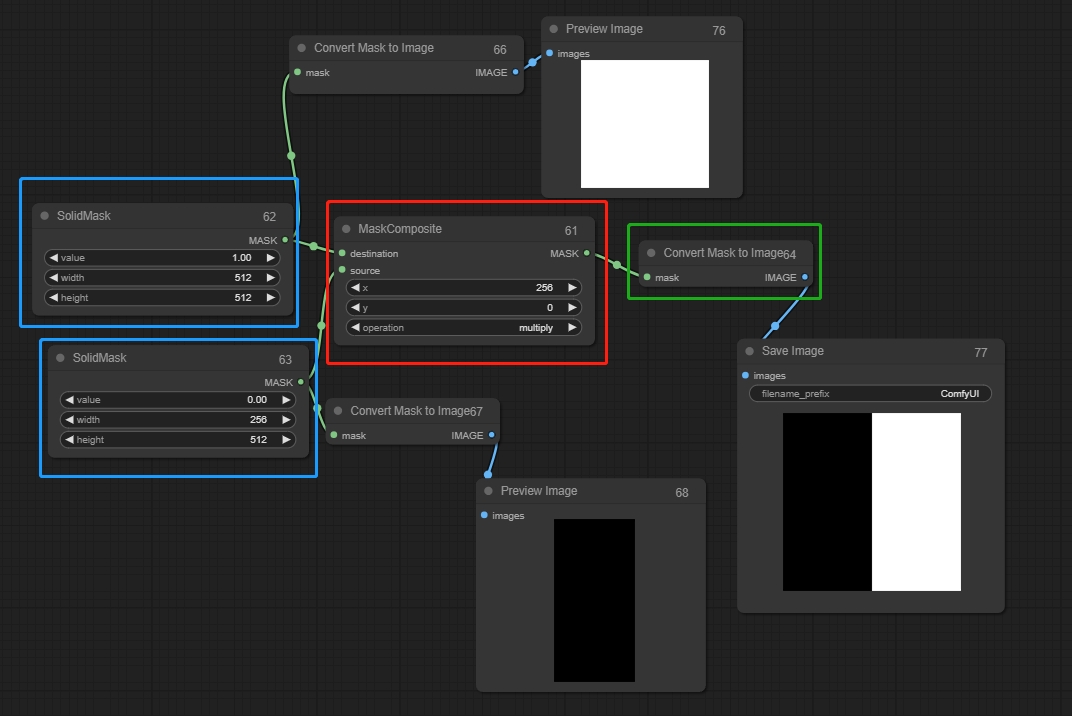

Solid Mask

Funciona como un lienzo para generar imágenes y puede combinarse con Mask Composite.

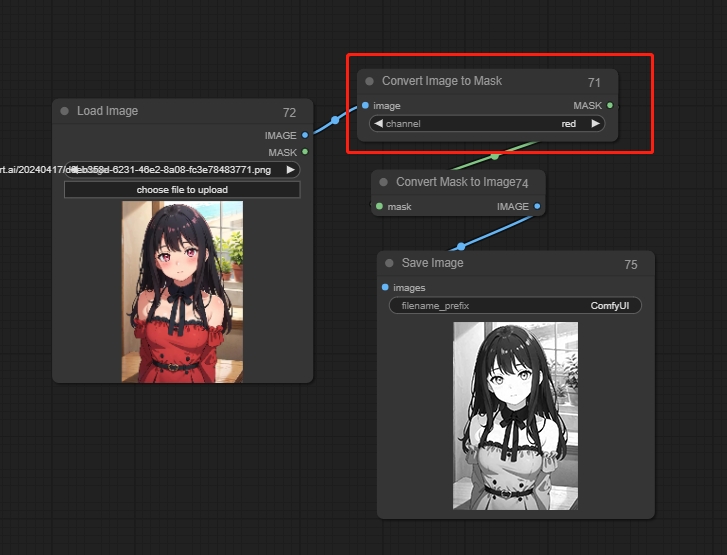

Convert Mask To Image

Convert Image To Mask

Convierte la máscara en una imagen en escala de grises.

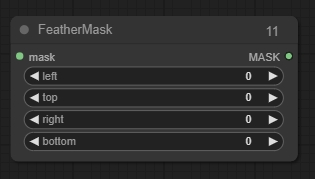

Feather Mask

Aplica un difuminado (feathering) a la máscara.

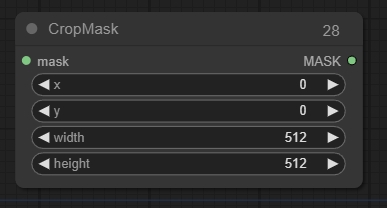

Crop Mask

Recorta la máscara a una nueva forma.

Mask Composite

Pega una máscara dentro de otra, conectando Solid Mask. Un valor de 0 representa negro, que no se dibujará, mientras que un valor de 1 representa blanco, que sí se dibujará. Los valores en las dos Solid Masks conectadas deben ser diferentes; de lo contrario, la máscara no tendrá efecto.

Entrada:

destination(1): La máscara en la que se va a pegar, equivalente a las dimensiones finales de la imagen.

source(0): La máscara que se va a pegar.

Parámetros:

X, Y: Ajustan la posición de la máscara fuente.

operation: Cuando el valor es 0, se utiliza la operación multiplicar; cuando es 1, se utiliza la operación sumar.

Sampler

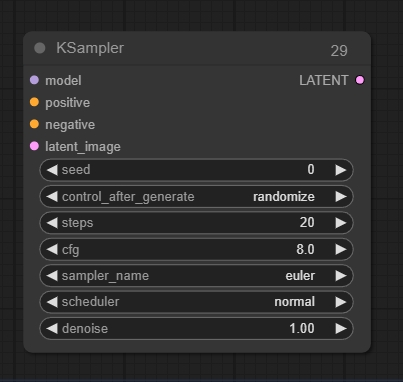

KSampler

Entrada:

latent_image: La imagen latente que se va a eliminar el ruido.

Salida:

LATENT: La imagen latente después de la eliminación de ruido.

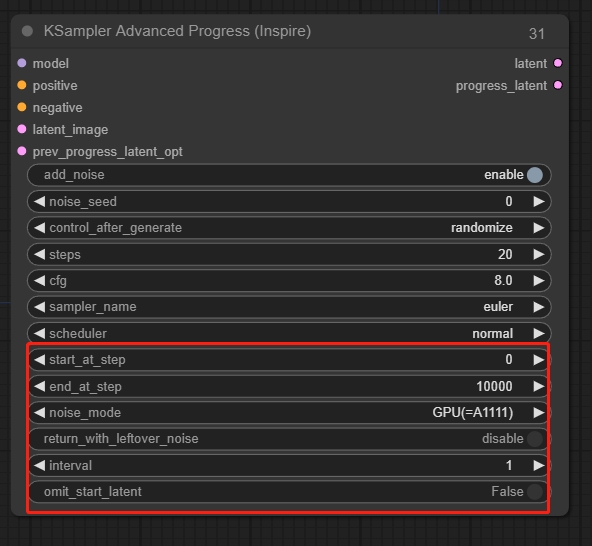

KSampler Advanced

Puedes controlar manualmente el ruido.

Advanced

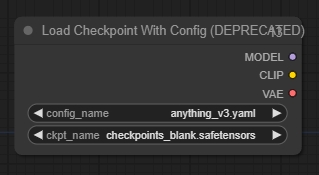

Load Checkpoint With Config

Carga el modelo de difusión basado en el archivo de configuración proporcionado.

Otros nodos(actualizando)

AIO Aux Preprocessor

Selecciona diferentes preprocesadores para generar las imágenes correspondientes.